Hoy nuestro día a día surgen alrededor de las preguntas; todos los días hacemos decenas de preguntas y preguntas, a buscadores como Google, en la cual mágicamente como si un robot tuviera todo listo nos muestra un resultado de búsqueda en base a lo que preguntamos; sin embargo te has parado a preguntar cómo es esto posible, de donde salen estos resultados mágicamente que aparecen en nuestra pantalla. Pero pocas veces nos detenemos a pensar cómo es posible que esos resultados aparezcan tan rápido y tan bien organizados.

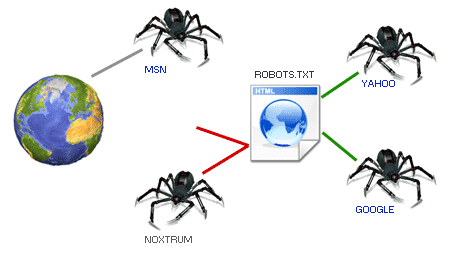

La respuesta está que estos buscadores como Google están siempre buscando nuevos sitios y analizados los ya existentes, siempre en busca de datos y uno de los archivos pioneros en lo que se refiere a trabajar con los buscadores para que indexen nuestra web son los robots.txt.

Uno de los archivos más importantes para comunicarnos con ellos desde nuestra web es el robots.txt, un archivo pequeño, sencillo, pero clave para el SEO y la correcta indexación de un sitio web.

Cómo funcionan los buscadores y por qué existen los robots

Qué son los robots, bots, arañas o rastreadores

Los robots (también llamados bots, arañas o crawlers) son programas automatizados que recorren Internet de forma constante. Su misión es visitar páginas web, analizar su contenido y decidir qué información merece ser indexada en los motores de búsqueda.

Entender esto cambia por completo la forma en la que ves tu web: no estás escribiendo solo para personas, también para robots.

Cómo Google y otros buscadores “leen” una web

Cuando un robot llega a un sitio web, no empieza a rastrear sin más. Antes de hacer nada, busca un archivo muy concreto en la raíz del dominio: el robots.txt. Ese archivo actúa como una primera guía que le indica por dónde puede y por dónde no debería pasar.

El archivo robots.txt no es más que un archivo de texto plano con extensión .txt que permite evitar que ciertos robots que analizan los sitios web agreguen información innecesaria; incluso permite bloquear a estos robots; en otras palabras; permite indicar pautas o recomendaciones de cómo indexar nuestro sitio web por los distintos robots.

Los robots son generalmente buscadores que acceden a las páginas que componen nuestro sitio para así analizar; estos también son llamados bots, arañas, rastreadores, etc.

También podemos especificar a las arañas o los rastreadores que pueden rastrear o indexar y qué partes no pueden acceder o no deben acceder, es decir, que estas son simplemente recomendaciones, pero esto no garantiza que a la final la araña no intente meterse en partes que no queremos.

Este es un archivo que esta ligado directamente con la organización de nuestro sitio, en el mismo indicamos que partes de nuestra web esta o no visible y con esto indicar como está organizado nuestro sitio web, por tal motivo, es fundamental que esté bien programado y para eso puedes seguir las pautas señaladas en esta entrada.

Algunos robots conocidos

- Googlebot: El buscador de Google; con el cual descubre páginas nuevas y actualiza las existentes.

- Mediapartners-Google: El robot de Google que encuentra páginas con adsense.

- Bingbot: El buscador de Microsoft; al igual que en el caso del buscador de Google, con bingbot, Microsoft descubre páginas nuevas con las cuales Bing se alimenta.

Estos por citar algunos de los más importantes; pero hay muchos más.

Cuando un robot va a analizar un sitio web lo primero que hace es buscar el robots.txt en la raíz del web para saber qué páginas tiene que indexar y ver si existe alguna sección del sitio web que no debería debería recorrer ni indexar.

¿Para qué sirve el robots.txt?

Si decidimos emplear un robots.txt en nuestra web podremos lograr una serie de beneficios:

- Prohibir zonas: Este es uno de los usos más habituales, consiste básicamente en tener zonas en nuestra sitio web que no aparezcan en los buscadores; por ejemplo la sección de administración del sitio, logs del sitio web, o cualquier otro contenido que no deseamos que sea localizado por estos robots.

- Eliminar contenido duplicado: Los buscadores nos darán una mejor ponderación si evitamos duplicar contenido.

- Evitar sobrecargar el servidor: De esta forma podemos evitar que un robot sature al servidor con solicitudes excesivas al mismo.

- Indicar el mapa del sitio (sitemap).

- Bloquear robots: Hay "robots malos" cuyo único fin es rastrear la web en busca de email para hacer Spam, por citar algún caso.

Si nuestro sitio web no va a tener "zonas prohibidas", ni tampoco sitemap, ni tiene contenido duplicado; entonces no debemos de incluir el robots.txt en el sitio web; ni siquiera vacío.

¿Para qué no sirve el robots.txt?

Como hemos mencionado a lo largo del artículo, el robots.txt establece recomendaciones de como indexar nuestro sitio; pero algunos robots (que llamaremos "robots malos") pueden no respetar estas recomendaciones por distintos motivos:

- Si el sitio web posee información sensible o delicada y no quieres que pueda ser localizada por los buscadores, es recomendable utilizar algún medio de seguridad para proteger la información.

Definición sencilla del archivo robots.txt

El archivo robots.txt es un archivo de texto plano (con extensión .txt) que sirve para indicar a los robots de los motores de búsqueda qué partes de una web pueden rastrear y cuáles no.

No es un archivo complejo ni tiene código avanzado: precisamente su fuerza está en su simplicidad.

Dónde se ubica y por qué siempre está en la raíz del sitio

El robots.txt siempre debe estar en la raíz del dominio, por ejemplo:

https://tusitio.com/robots.txt

Si no está ahí, los robots no lo tendrán en cuenta. Por eso se dice que es uno de los archivos “pioneros” en la comunicación entre una web y los buscadores.

Características del robots.txt

Algunas de las principales características que debe cumplir con el robots.txt, son las siguientes:

- Este archivo debe ser único en nuestro sitio web.

- Archivo sin formato.

- Las urls son sensibles a mayúsculas y minúsculas y no hay que dejar espacios en blanco entre líneas.

- El archivo debe estar en la raíz del sitio web

- Indica la localización del sitemap o mapa del sitio web en XML.

¿Cómo creamos el archivo robots.txt?

El archivo robots.txt debe estar almacenado en la raíz de nuestro servidor; es un archivo que cualquiera puede acceder desde su navegador y el mismo debes crear o subir un archivo llamado "robots.txt"; así de fácil; a la final tu ruta debe quedar como:

https://tuweb.com/robots.txt

User-agent: Este como su nombre indica corresponde al agente de usuario; existen varios tipos y hace referencia a los robots o arañas de los motores de búsqueda; puedes ver una colección de ellos en el siguiente enlace Robots Database. Su sintaxis sería:User-agent: -Nombre del robot-- Disallow: Indica a la araña que no deseamos que acceda ni trastree una URL, subdirectorio o directorio de nuestra página web o aplicación.

Disallow: -recurso que quieres bloquear- - Allow: Al contrario del anterior, indica que URL carpetas o subcarpetas deseamos que analice e indexe.

Allow: -recurso que quieres indexar Sitemap: Indica la ruta de nuestro sitemap o mapa del sitio en XML.

Para simplificar las reglas que detallamos anteriormente, puedes emplear unos caracteres en especial: *, ?, $; el asterisco para indicar todos, el dólar para indicar la terminación de un recurso (por ejemplo, para referenciar a todos los archivos PHP /*.php$) y el signo de interrogación para indicar que coindice con el final de la URL.

Por ejemplo, para indicar en el archivo robots.txt que quieres impedir a todas las arañas que un directorio en particular es privado puedes aplicar las siguientes reglas:

- User-agent: * Disallow: /carpeta-privada/

Solo quieres excluir al robot de Google:

- User-agent: Googlebot Disallow: /carpeta-privada/

O el de Bing:

User-agent: Bingbot Disallow: /carpeta-privada/

- La siguiente regla nos sirve para indicar que todas las carpetas que contengan

carpeta-privadaserán privadas. - User-agent: * Disallow: /carpeta-privada*/

Para bloquear una URL:

- Disallow: /android/mi-pagina-bloqueada.html

Ejemplo de archivo robots.txt

User-Agent: * Disallow: /carpeta-privada*/ Disallow: /admin/ Allow: /uploads/images/ Sitemap: https://tuweb.com/sitemap.xml

En el ejemplo anterior, estamos indicando a todos las arañas que no indexen ni procesen las carpetas que contengan carpeta-privada ni la carpeta admin, pero que si procese los recursos en /uploads/images/ y también le estamos diciendo dónde está nuestro mapa del sitio.

Si queremos indicar que el contenido de nuestras imágenes es permitido, a todos los agentes, y además, indicar donde está nuestro Sitemap:

Aunque recuerda que esto son solo recomendaciones que se hacen a las arañas de búsqueda para que no indexen una carpeta o recurso en particular.

Para qué sirve el archivo robots.txt en una web

Controlar qué partes de la web se rastrean o no

Uno de los usos más habituales del robots.txt es bloquear zonas que no tienen sentido para los buscadores, como:

- Paneles de administración

- Carpetas técnicas

- Archivos temporales

Evitar contenido duplicado y mejorar el SEO

En más de una ocasión me he encontrado con webs que posicionaban peor simplemente por permitir que Google indexara URLs duplicadas o poco relevantes. El robots.txt ayuda a enfocar el rastreo en lo realmente importante.

Reducir carga del servidor y optimizar el presupuesto de rastreo

Los robots consumen recursos del servidor. Usar bien el robots.txt permite evitar rastreos innecesarios y optimizar el llamado presupuesto de rastreo, especialmente importante en sitios grandes.

Indicar la ubicación del sitemap.xml

Otro uso muy común es indicar dónde se encuentra el sitemap:

Sitemap: https://tusitio.com/sitemap.xmlEsto facilita que los buscadores encuentren todas las páginas relevantes.

Qué NO hace el robots.txt (limitaciones importantes)

- Por qué robots.txt no es un sistema de seguridad

- Algo que conviene dejar muy claro: robots.txt no protege información sensible. Es solo una recomendación. Cualquier persona puede escribir /robots.txt en tu dominio y ver su contenido.

- Qué pasa con los bots que no respetan las reglas

- Los robots “buenos” (Google, Bing, etc.) suelen respetar estas directrices. Sin embargo, los bots maliciosos pueden ignorarlas por completo, por lo que nunca debe usarse robots.txt como medida de seguridad.

Robots.txt y la inteligencia artificial: lo que debes saber hoy

- Bots de IA vs bots de buscadores tradicionales

- En los últimos años han aparecido bots de IA cuyo objetivo no es solo indexar contenido, sino recopilar datos para entrenar modelos. Estos bots generan muchas más peticiones y no siempre se comportan igual que los rastreadores clásicos.

- ¿Se puede bloquear el acceso de la IA con robots.txt?

- Sí, se pueden añadir reglas específicas para determinados user-agents de IA, indicando que no accedan al contenido. Pero, al igual que con otros bots, no es una garantía absoluta.

- Limitaciones reales al impedir el entrenamiento de modelos de IA

- Aquí es importante ser honesto: el robots.txt no puede impedir al 100 % que tu contenido sea usado para entrenamiento de IA. Funciona como una señal de intención, no como una barrera técnica.

- Buenas prácticas actuales para controlar rastreadores de IA

- Identificar bots conocidos de IA y crear reglas específicas

- Combinar robots.txt con medidas de servidor (firewalls, rate limiting)

- No confiar únicamente en robots.txt para proteger contenido estratégico

Principales directivas del archivo robots.txt

User-agent: a qué robot se aplican las reglas

Indica a qué robot afectan las instrucciones:

User-agent: GooglebotO a todos:

User-agent: *Disallow: bloquear archivos, carpetas o URLs

Sirve para indicar qué no debe rastrearse:

Disallow: /admin/Allow: permitir excepciones

Permite autorizar subrutas dentro de carpetas bloqueadas:

Allow: /privado/documentos/Sitemap: indicar el mapa del sitio

Facilita el rastreo:

Sitemap: https://tusitio.com/sitemap.xmlCrawl-delay: cuándo usarlo y cuándo no

Indica un tiempo de espera entre peticiones. Ojo: Google no lo respeta, aunque otros buscadores sí.

Ejemplos prácticos de robots.txt

Bloquear una carpeta privada

User-agent: *

Disallow: /carpeta-privada/Bloquear solo Google o solo Bing

User-agent: Googlebot

Disallow: /privado/Bloquear archivos por extensión

User-agent: *

Disallow: /*.pdf$Ejemplo completo de robots.txt bien configurado

User-agent: *

Disallow: /admin/

Disallow: /carpeta-privada*/

Allow: /uploads/images/

Sitemap: https://tusitio.com/sitemap.xmlErrores comunes al configurar robots.txt

- Bloquear todo el sitio por error

- Un simple Disallow: / puede hacer desaparecer tu web de Google.

- Usar robots.txt cuando debería usarse noindex

- Para páginas ya indexadas, noindex suele ser más efectivo.

- Confiar en robots.txt para proteger información sensible

- Nunca es una solución de seguridad real.

Cómo comprobar si tu robots.txt funciona correctamente

- Verificación con Google Search Console

- Google ofrece una herramienta específica para probar el archivo robots.txt y detectar errores.

- Comprobaciones manuales básicas

- Basta con acceder desde el navegador a:

- https://tusitio.com/robots.txt

- y revisar su contenido.

Conclusión: cuándo usar robots.txt y cuándo no

El archivo robots.txt es una herramienta fundamental para organizar y comunicar cómo debe rastrearse tu web, mejorar el SEO y optimizar recursos. En mi caso, entender su funcionamiento marcó un antes y un después a la hora de estructurar proyectos web.

Eso sí, conviene no sobrevalorar su poder: no es seguridad, no es una orden y no es infalible, especialmente en el contexto actual de bots de IA.

Usado con criterio, sigue siendo una pieza clave del SEO técnico.

Preguntas frecuentes sobre el archivo robots.txt

- ¿Es obligatorio tener un robots.txt?

- No, solo es recomendable si necesitas controlar el rastreo.

- ¿Bloquear en robots.txt elimina páginas de Google?

- No necesariamente; para eso es mejor noindex.

- ¿Los bots de IA respetan el robots.txt?

- Algunos sí, otros no. Es solo una recomendación.

Conclusiones

Agregar el archivo robots.txt a nuestra web es recomendable ya que es una forma de organizar nuestra sitio web, indicando a los robots que sitios no son accesibles, donde hay contenido duplicado, donde está el sitemap de nuestra web, entre otros; pero debemos recordar que estas son solo recomendaciones; es decir no evitará que un robot malicioso acceda a las zonas que se han deshabilitado en el robots.txt; además de esto el robots.txt es un archivo público el cual puede ser accedido y consultar su contenido por cualquier ente con un navegador web.