Bienvenidos a este curso completamente gratis de Docker para desarrolladores. ¿Y a qué me refiero con desarrolladores? A desarrolladores web, así de simple. Hay muchas facetas para emplear Docker y, en este caso, te voy a explicar lo mínimo y necesario para que puedas utilizar Docker en tus proyectos web.

¿Qué vamos a ver?

Vamos a conocer las bases de Docker. Ese viene siendo el primer punto que vamos a tratar: lo que es Docker per se, su ecosistema, qué demonios nos trae, el uso de contenedores, imágenes y, un poco más adelante, volúmenes.

A partir de ahí, vamos a crear nuestro primer Dockerfile para que podamos arrancar un proyecto, pero rápidamente nos daremos cuenta de que simplemente virtualizar un proyecto está bastante bien… pero ¿qué pasa con los servicios? ¿Qué pasa si quiero colocar Redis, si quiero colocar MySQL o cualquier otra cosa para la que exista una imagen?

Para eso tenemos que utilizar Docker Compose, para que podamos orquestar múltiples servicios como si fuera simplemente una aplicación única mediante contenedores.

Herramientas que utilizaremos

Vamos a emplear principalmente la línea de comandos, ya que es la herramienta más potente que tenemos. Pero también nos vamos a apoyar bastante en la parte visual con la interfaz gráfica. Cuando instalamos Docker -y esto también lo hablo en el video correspondiente- instalamos dos cosas principalmente:

- La interfaz gráfica.

- La línea de comandos.

Aquí lo que quiero darte es lo mínimo necesario, para que sea lo más corto posible. Y, a partir de conocer esos tres aspectos que te acabo de mencionar -las bases de Docker, el Dockerfile y Docker Compose para orquestar todo-, vamos a configurar algunos proyectos de ejemplo.

Proyectos que configuraremos

- Laravel, con Sails -que eso se escapó un poquito de las manos porque es una herramienta que realmente está por encima de todo lo mencionado-.

- Vamos a configurar un proyecto en Flask, en FastAPI, en Django, en CodeIgniter, y básicamente eso es lo que vamos a realizar.

Esta es una formación básica para aprender a usar Docker, por lo tanto, SOLAMENTE tratamos los elementos básicos y necesarios para que puedas empezar ha realizar administrar Docker y hacer el deploy de tus primeros proyectos; en esta página tienes la documentación completa:

https://docs.docker.com/get-started/

Conceptos Claves

Como en todo en la vida, primero debemos tener claros algunos conceptos antes de pasar a la práctica. En los frameworks usualmente hablamos del patrón MVC, MTV, entre otros.

Y aquí ocurre lo mismo: necesitamos entender cómo está formado este programa llamado Docker. ¿Qué demonios es esto? Porque créeme que cuando pasemos a la práctica, todo se entenderá mucho más fácilmente.

Similitudes con Python, los ambientes virtuales, Node y PHP

El uso de contenedores, imágenes y Docker es muy similar a los ambientes virtuales en Python.

- Python usa Pipenv, Conda, o simplemente venv.

- Laravel y Node instalan dependencias dentro del proyecto (vendor/, node_modules/).

Pero Python instala por defecto todo a nivel del sistema operativo, lo cual es un problema.

Ejemplo práctico:

Tienes un proyecto hecho en Django hace 3 años (versión Django 4), y hoy necesitas crear otro proyecto pero con Django 7.

Si instalaras todo directo en el sistema operativo, choque asegurado.

Y no solo pasa con Python:

- No puedes tener 3 PHP diferentes activos en el mismo sistema.

- Tampoco puedes mezclar dependencias de forma desordenada sin aislar cada proyecto.

- Por eso, en Python creamos un ambiente virtual por proyecto, lo cual encapsula y aísla sus dependencias. Y es justo ahí donde aparece el paralelismo con Docker.

¿Dónde se guardan las dependencias?

En Laravel tenemos vendor/, en Node tenemos node_modules/.

En Python, el equivalente es una carpeta llamada usualmente .venv o .pvenv, donde se guardan solo las dependencias de ese proyecto.

Eso no ocurre automáticamente: tú debes instalar y activar el ambiente virtual, igual que con Docker, que también debes instalar y configurar manualmente.

Con esto, puedes entender para que podemos usar Docker, como un ambiente en donde podemos ejecutar de manera aislada nuestros proyectos y las similitudes con imágenes y contenedores, en las cuales, las imágenes son simplemente las dependencias, como ocurre con dependencias como Django o Laravel, que son simplemente archivos estáticos y contenedores, que es cuando ya se estan ejecutando o interpretan las imágenes.

Docker

Docker es una plataforma que permite “empaquetar” aplicaciones con todas sus dependencias (librerías, configuración, etc.) para que puedan ejecutarse de forma consistente en cualquier entorno (tu máquina, servidores, nube).

Puedes ver Docker como una especia de ambiente virtual, como los que tenemos en Python mediante los venv, en el cual, podemos instalar paquetes (imágenes sería el equivalente en Docker) que son las dependencias de nuestro proyecto; la ventaja de esto, es que, se ejecutan de manera aislada del sistema operativo; con esto, podemos tener múltiples dependencias con versiones distintas para proyectos distintos instalados en el mismo sistema operativo pero, virtualizado mediante los contenedores en Docker; por ejemplo, podemos tener múltiples versiones de Python instaladas para distintos proyectos.

Otro ejemplo, es como la carpetas vendor de PHP o de node_modules de Node, en la cual, tenemos las dependencias (imágenes sería el equivalente en Docker) para cada proyecto; no es exactamente esto, pero, con esta idea te será más fácil entender como funciona Docker

Docker no es solo una herramienta de desarrollo y se usa ampliamente en producción, y Railway es un ejemplo muy claro de ello.

Imagen (Image)

Una imagen de Docker es como una “plantilla” inmutable, es decir, de solo lectura que contiene todo lo necesario para ejecutar una aplicación: sistema de archivos, dependencias, código, variables de entorno, etc; con esto, se crean los contenedores en Docker que es el siguiente punto que vamos a tratar.

- Las imágenes están formadas por capas (layers) que representan cambios incrementalmente aplicados unas sobre otras.

- Una vez creada, no se modifica: si quieres cambiar algo, creas una nueva imagen o haces “build” sobre una base existente.

Imagina que una imagen de Docker es como un archivo .exe en tu computadora.

El .exe contiene todo el código y los recursos necesarios para ejecutar un programa (bibliotecas, dependencias, configuraciones...), pero mientras no lo ejecutes, el programa no está corriendo ni ocupa recursos.Del mismo modo, una imagen de Docker es un paquete estático que incluye el sistema base, el entorno, las dependencias y la aplicación lista para funcionar. Pero no hace nada por sí sola hasta que creas un contenedor a partir de ella —que sería el equivalente a ejecutar el .exe.

Otra analogía es con las clases, una clase definida:

class Category(models.Model):

title = models.CharField(max_length=500)

slug = models.SlugField(max_length=500)Es como una imagen, por si, no hacemos nada con ella, pero es cuando la ejecutamos (un contenedor) es decir, creamos una instancia, es que se emplea dicha clase/imagen.

Una imagen es como una plantilla inmutable, de solo lectura.

Es una referencia, un entorno con su sistema base y dependencias incluidas.

Ejemplos reales de imágenes disponibles:

- python

- ubuntu

- nginx

- mysql

- postgres

Contenedor (Container)

Un contenedor es la instancia en ejecución de una imagen. Piensa en la imagen como el plano o molde, y el contenedor como la casa construida a partir de ese plano.

Una vez que lanzas un contenedor, este funciona como un proceso aislado, con su propio sistema de archivos (basado en la imagen), entorno, red, etc.

Los contenedores comparten el kernel del sistema operativo host, lo que los hace más ligeros que máquinas virtuales completas.

Al ser un proceso, puedes ejecutarlo, crearlo, detenerlo, moverlo o eliminar el proceso; para eso, se emplea comandos como docker create container, pull, cet:

$ docker run -i -t ubuntu /bin/bashImagina que un contenedor de Docker es como ejecutar un programa .exe en tu computadora.

Mientras la imagen de Docker es el archivo guardado en tu disco (listo pero inactivo), el contenedor es ese mismo programa ya en ejecución: con su ventana abierta, sus procesos corriendo y su propio entorno funcionando de forma independiente.

Cuando cierras el programa, el proceso termina, pero el .exe sigue allí intacto.

De igual forma, cuando detienes o eliminas un contenedor, la imagen original sigue disponible para crear otro contenedor nuevo en cualquier momento.

Los contenedores en Docker:

- Autocontenidos: cada contenedor incluye todo lo que necesita para funcionar, sin depender de programas o librerías instaladas en la máquina donde se ejecuta.

- Aislados: los contenedores se ejecutan de forma independiente del sistema y de otros contenedores, lo que mejora la seguridad y evita conflictos.

- Independientes: puedes crear, detener o eliminar un contenedor sin afectar a los demás. Cada uno se gestiona por separado.

- Portátiles: un contenedor puede ejecutarse en cualquier lugar. El mismo que usas en tu computadora funcionará igual en un servidor o en la nube.

Otros conceptos funcionales:

Docker Daemon (dockerd)

El Docker Daemon es el proceso que realmente ejecuta y administra todo en Docker.

Se encarga de:

- Crear y ejecutar contenedores.

- Descargar o construir imágenes.

- Manejar redes, volúmenes y otros recursos de Docker.

- Comunicarse con otros daemons (por ejemplo, en entornos distribuidos o en clústeres).

En resumen:

Es el “motor” de Docker, el que hace el trabajo pesado.

Normalmente corre en segundo plano como un servicio del sistema y es el que recibe los comandos recibidos por el cliente que es el siguiente apartado que vamos a comentar.

Docker Client (docker)

El cliente de Docker es la herramienta con la que tú interactúas — por ejemplo, cuando escribes comandos como:

docker run -d -p 8080:80 nginxEste comando no ejecuta el contenedor directamente.

El cliente simplemente envía una solicitud al daemon (usando la Docker API) diciéndole qué hacer, y el daemon es quien lo ejecuta realmente.

Además, un mismo cliente puede comunicarse con múltiples daemons (por ejemplo, un Docker local y otro remoto en la nube).

| Componente | Qué hace | Ejemplo |

| ---------------------- | -------------------------------------------------------- | --------------------------------------------------------- |

| Cliente (docker) | Recibe tus comandos. | docker build, docker run, docker ps |

| Daemon (dockerd) | Ejecuta las órdenes del cliente y gestiona los recursos. | Crea imágenes, inicia contenedores, configura redes, etc. |

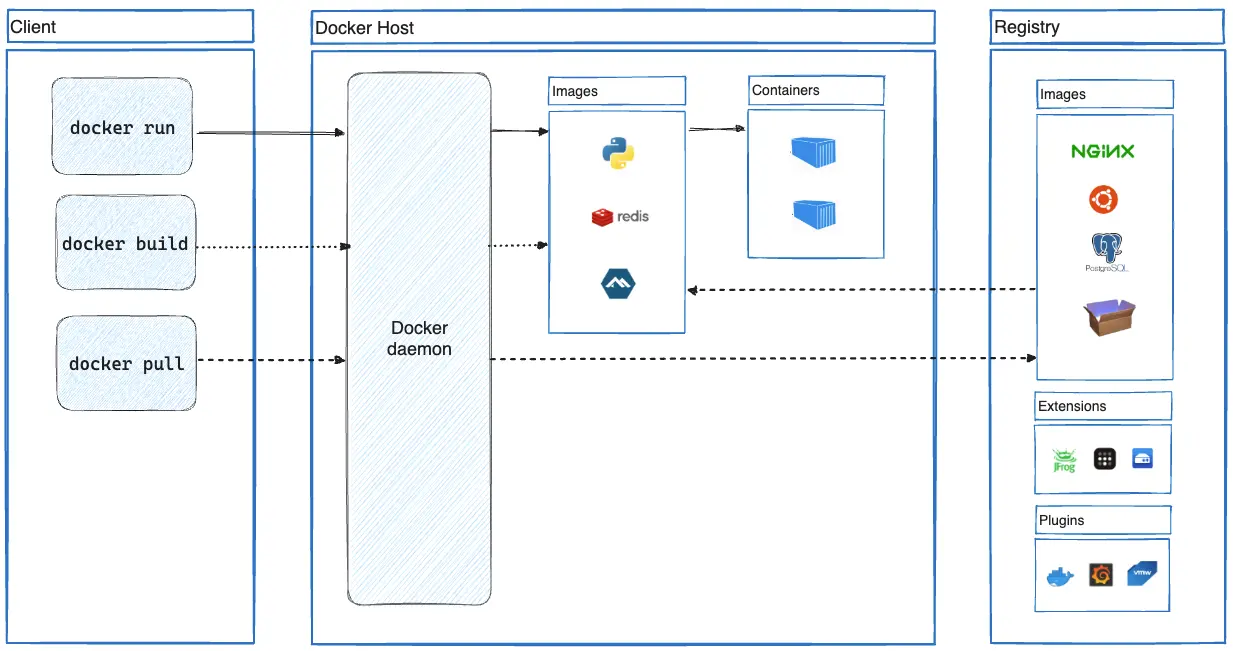

En esta imagen, tomada desde la web de Docker, puedes ver claramente la distinción entre el cliente Docker Client (docker) (los comandos) y el demonio de Docker (dockerd) que es el que recibe los comandos y hace los cambios a nivel de nuestras imágenes y contenedores, que SON LA PIEZA FUNDAMENTAL Y BÁSICA EN DOCKER:

Instalación

La instalación de Docker es muy sencilla. Para empezar, busca en Google “Docker Install”. Entre los resultados, selecciona la página oficial de Docker (Docker Start).

Una vez cargada la página, se mostrará la opción de descarga según tu sistema operativo: macOS, Windows, Linux, macOS con Intel, etc. Simplemente descárgalo e instálalo siguiendo los pasos habituales: Next, Next, Next.

Qué estamos instalando

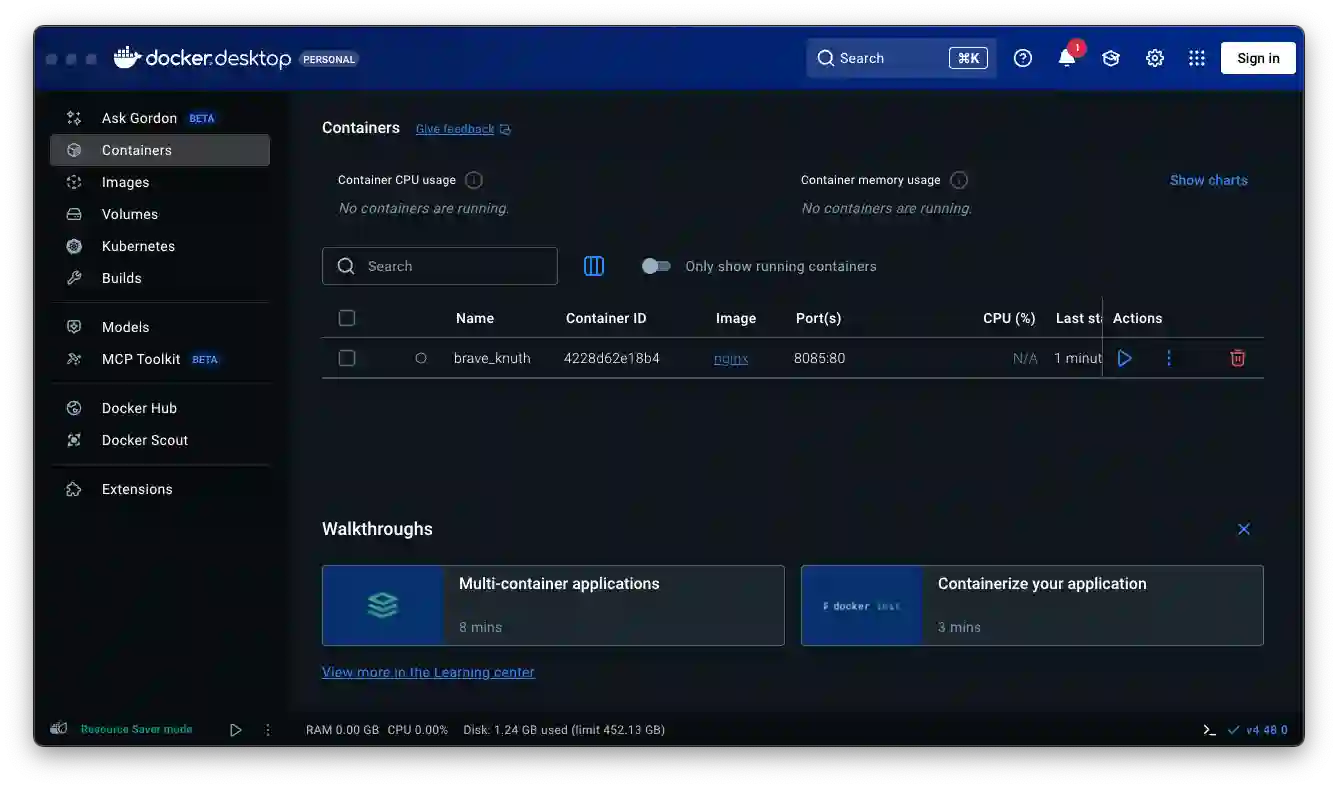

Al instalar Docker, se instalan dos componentes principales:

- Interfaz gráfica: te permite administrar contenedores y configuraciones de manera visual.

- CLI (Command Line Interface): la línea de comandos que te permite ejecutar comandos de Docker desde la terminal. Aunque el nombre suene técnico, es muy sencillo de usar.

Verificación de la instalación

Una vez finalizada la instalación, abre Docker y verás la interfaz gráfica cargando:

Para verificar la instalación de la CLI, abre cualquier terminal y escribe:

$ dockerSi todo está correcto, se mostrará la lista de comandos disponibles, confirmando que ambos componentes están instalados y listos para usar:

Usage: docker [OPTIONS] COMMAND

A self-sufficient runtime for containers

Common Commands:

run Create and run a new container from an image

exec Execute a command in a running container

ps List containers

build Build an image from a Dockerfile

bake Build from a file

pull Download an image from a registry

push Upload an image to a registry

images List images

login Authenticate to a registry

logout Log out from a registry

search Search Docker Hub for images

version Show the Docker version information

info Display system-wide informationComandos imprescindibles

En este listado, puedes ver algunas acciones que podemos realizar el Docker, como realizarlo mediante la CLI y su equivalente en la UI:

- docker images: Ver imágenes: docker images (Pestaña Images)

- docker run <ID / nombre>: Crear contenedor: docker run (Botón “Run” sobre una imagen)

- docker ps -a: Ver contenedores: docker ps -a (Pestaña Containers)

- docker logs <Container ID>: Ver logs: docker logs <id> (Sección “Logs”)

- docker stop <ID / nombre> / docker rm <ID / nombre>: Detener/eliminar: docker stop/docker rm (Botones Stop / Delete)

- docker rmi <ID / nombre> elimina una imagen

- docker exec -it bash Entrar dentro de un contenedor ACTIVO en modo interactivo (habilita el bash para lanzar comandos)

- docker run -it <Container ID>(Ej ubuntu) Crea el contenedor y lo deja en modo interactivo (habilita el bash para lanzar comandos)

Un comando imprescindible es el siguiente:

$ docker run -d -p 8080:80 nginx- docker run → Crea y arranca un nuevo contenedor.

- -d → Lo ejecuta en modo “detached” (en segundo plano, no se queda "pegado" en la terminal).

- -p 8080:80 → Expone el puerto 80 del contenedor en el puerto 8080 de tu PC.

- nginx → Usa la imagen oficial de Nginx desde Docker Hub.

Funcionamiento básico

Del comando anterior, quitando los aspectos técnicos como el detached, o la configuración de los puertos, tenemos dos aspectos fundamentales en Docker que es la imagen y el contenedor:

- Las imágenes descargadas (como nginx)

- Los contenedores que crea a partir de esas imágenes

Ver imágenes

En términos funcionales pasa lo siguiente:

- Descarga la imagen nginx desde Docker Hub (si no la tienes ya, si quieres ver las imágenes, recuerda docker images).

- Crea un contenedor en su propio entorno interno y NO en una carpeta en particular.

- Expone el puerto 80 del contenedor en el puerto 8080 de tu host (tu Mac), gracias a la red virtual que Docker configura.

$ docker images

>> REPOSITORY TAG IMAGE ID CREATED SIZE

>> nginx latest 3b7732505933 12 days ago 255MB

$ docker run 3b7732505933

O

$ docker run nginx

No le estás diciendo ni que se quede activo, ni qué puertos exponer, así que parece “que no pasó nada”. En realidad sí se ejecutó, pero se cerró inmediatamente o quedó corriendo sin exponer nada.En el caso anterior, NO tiene sentido ejecutar la imagen de nginex ya que, la misma para poder levantar el proceso satisfactoriamente, se debe de especificar las opciones del puerto, como hicimos antes:

$ docker run -d -p 8080:80 nginxO mediante redis:

$ docker run -d redisRedis si podría trabajar sin exponerle el puerto ya que, por defecto el queda escuchando en el puerto 6379 y por lo tanto, para la implementación anterior, solo sería accesible desde otros contenedores Docker, es decir, de manera interna y no desde el PC perse (fuera de Docker).

Ver Contenedores

Si quisiéramos ver los contenedores de Docker (desde la UI lógicamente la pestaña de Contenedores):

Inicialmente, vamos a ejecutarlo sin el parámetro -a. Para este ejemplo, seguramente en tus pruebas anteriores también tendrás algo. Yo tengo un par de contenedores de las pruebas que hicimos con docker run, ya que, recordemos, cuando ejecutamos docker run con parámetros o sin parámetros, siempre se crea algún contenedor. Entonces, yo tengo al menos dos con los cuales trabajar

Muestra SOLO los contenedores que están corriendo/ejecutandose:

$ docker ps

>> CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

>> e678f12698bf nginx "/docker-entrypoint.…" 3 days ago Exited (0) 5 minutes ago peaceful_mclaren

>> c880881a55f8 3b7732505933 "/docker-entrypoint.…" 3 days ago Exited (0) 3 days ago modest_northcuttFíjate que nos devuelve información sobre el contenedor o los contenedores. Aquí aparece algo interesante, que se apoya en lo comentado antes: los contenedores son la pieza de ejecución de las imágenes.

Si no tienes nada iniciado, no verás absolutamente nada. Pero, ¿qué pasa si agregamos el parámetro -a?

Muestra TODOS los contenedores:

$ docker ps -aEn ambos casos:

>> CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMESAhora aparecen los contenedores que tenemos. La opción -a devuelve todos los contenedores, sin importar si están iniciados o no. Por otro lado, docker ps sin parámetros muestra únicamente los contenedores que se están ejecutando.

Ver las imágenes:

$ docker images

>>> REPOSITORY TAG IMAGE ID CREATED SIZE

>>> nginx latest 3b7732505933 12 days ago 255MBEn resumen:

- docker ps -a → todos los contenedores (activos o inactivos).

- docker ps → solo los contenedores activos.

¿Por qué se llama ps y no containers?

Seguramente te preguntas: “Si para las imágenes usamos docker image, ¿por qué aquí no usamos docker containers?”

Esto es una tradición de Linux: ps significa process status, es decir, el estado del proceso. Un contenedor es, esencialmente, un proceso iniciado.

El término containers es más moderno y se incorporó alrededor de 2017, pero el comando ps se mantiene como legacy, una convención histórica de Docker.

Con estos conceptos, podemos entender mejor los fundamentos de Docker: las imágenes como base y los contenedores como piezas clave para ejecutar esos procesos.

Eliminar imágenes

Al igual que siempre, podemos pasarle el ID o el nombre de la imagen que queremos eliminar.

Por ejemplo, si tenemos una imagen llamada nginx, podemos escribir:

$ docker rmi nginx - rmi significa remove image

¿Qué significa RMI?

RMI significa Remove Image, tal como antes teníamos con Docker RM, pero esta vez la I indica que se trata de una imagen. Con esto, ya queda bastante claro su propósito.

Detener contenedores

Docker Stop, como pueden suponer, lo que hace es detener un contenedor. A mí me gustaría que se llamara docker container stop, que sería un poco más claro, pero bueno, así es como está implementado. En la siguiente clase veremos el comando equivalente para eliminar un contenedor.

Para detener un contenedor, simplemente debemos pasarle una de dos cosas:

- El identificador del contenedor (ID).

- El nombre del contenedor.

Fíjate que los parámetros, como el nombre, se pueden personalizar, pero eso lo veremos más adelante.

Identificando contenedores

Recordemos que anteriormente usamos docker ps, que nos devuelve información sobre los contenedores en ejecución. Allí podemos ver tanto el ID como el nombre del contenedor, lo que nos permite copiarlos y pegarlos fácilmente para usar con docker stop.

Deteniendo contenedores

Para detener un contenedor, este debe estar iniciado.

Usando el nombre:

$ docker stop nombre_del_contenedorResultado: se detuvo correctamente.

Usando el ID:

$ docker stop ID_del_contenedorEliminar contenedores

Para eliminar un contenedor es similar al de detener y el contenedor debe estar detenido, ejecutamos:

Usando el nombre:

$ docker rm nombre_del_contenedorO usando el ID:

$ docker rm ID_del_contenedorLogs contenedores

Permite ver los logs de un contenedor:

$ docker logs -f --tail 20 -t contenedor- --tail = cuántas líneas quieres ver

- --tail 20 últimas 20 líneas

- -t = (timestamp) agrega la hora a cada línea

- -f = (follow) queda "escuchando", y te muestra todo lo nuevo que vaya saliendo en vivo, sin cerrar (el contenedor debe de estar ejecutándose)

Modo Interactivo bash

El siguiente comando que quiero comentar es Docker Exec, que nos permite ejecutar comandos dentro de un contenedor.

Consideraciones previas

Es importante entender que el contenedor debe estar habilitado y en ejecución. Dependiendo de la imagen, ejecutar comandos puede ser extremadamente útil:

- Si tenemos una imagen como Ubuntu, podemos interactuar directamente con el sistema operativo.

- Si es un Apache o Nginx, probablemente no sea posible ejecutar comandos de manera interactiva.

- A menos que quieras modificar archivos: docker exec -it <apache-container> tail -f /var/log/apache2/error.log

- En el caso de bases de datos, podemos ejecutar comandos SQL directamente.

En resumen, todo depende del propósito de la imagen.

El modo interactivo es simplemente habilitar una terminal en la cual ejecutar comandos; para ello, se emplean los siguiente modos:

- -i (interactive) Deja escribir comandos en la terminal

- -t (tty (terminal)) Te da una terminal “real”

Ejemplos:

$ docker run -it ubuntu

$ docker exec -it a1b2c3d4e5 bash # a1b2c3d4e5 EJ de ID de un contenedor ejecutandoseDependiendo de la imagen, puede que si tenga sentido ejecutar comandos; por ejemplo, un shell interactivo de Ubuntu:

$ docker run -it ubuntuUn poco más elaborado:

$ docker run -d --name mi-ubuntu ubuntu sleep 1000- -d → lo ejecuta en segundo plano

- --name mi-ubuntu → le da un nombre para no usar el ID

- ubuntu → la imagen base

Entrar al contenedor con bash:

$ docker exec -it a1b2c3d4e5 bash

$ docker exec -it mi-ubuntu bashAhora estás dentro del contenedor.

Puedes ejecutar comandos como en cualquier Linux:

$ ls

$ pwd

$ apt updateDiferencia con Docker Run -it

- Docker Run -it: inicia un contenedor y automáticamente abre una terminal interactiva.

- Docker Exec -it: ingresa en un contenedor que ya está activo, permitiéndonos ejecutar comandos.

Para qué sirve sleep 1000

Cuando haces:

docker run -d --name mi-ubuntu ubuntu sleep 1000sleep 1000 es el comando que corre dentro del contenedor.

Mantiene el contenedor activo por 1000 segundos (unos 16 minutos).

Como usamos -d (detached / en segundo plano), el contenedor necesita un proceso que siga corriendo, si no, Docker lo detendrá inmediatamente.

¿Qué pasa si no pones sleep?

docker run -d --name mi-ubuntu ubuntuUbuntu no tiene un proceso por defecto que se quede corriendo.

Entonces el contenedor arranca y se detiene al instante, porque no hay nada que mantener activo.

Si luego haces docker ps, no lo verás en la lista de contenedores activos, solo en docker ps -a como Exited.

✅ Por eso usamos sleep para mantenerlo vivo y poder entrar con docker exec -it <id> bash.

Comando docker stats

Vamos a conocer el comando docker stats, que sirve para ver estadísticas de uso de recursos en los contenedores (de ahí su nombre).

$ docker statsPor ahora no tengo contenedores en ejecución, así que, si ejecuto el comando al inicio, no mostrará absolutamente nada.

Para tener algo que analizar, ejecutemos una imagen, por ejemplo, la de Nginx.

El comando sería algo así:

$ docker run -d --name my-nginx -p 8080:80 nginxPor aquí puedes ver que se muestra:

- La memoria total disponible en el equipo (en este caso, unos 7.5 GB).

- El consumo del contenedor Nginx.

- El uso de CPU asignado al contenedor.

Limitando recursos de un contenedor

Muchas veces queremos limitar la cantidad de recursos que asignamos a un contenedor.

Recordemos que el contenedor representa la parte de ejecución de una aplicación, por lo que es buena práctica establecer límites.

Por ejemplo, podemos usar las opciones --memory y --cpus al crear el contenedor:

$ docker run -d --name my-nginx --memory="50m" --cpus="0.5" nginxSi ejecutamos nuevamente docker stats, veremos que el límite ya no es de 7 GB, sino de 50 MB.

Probando el consumo del contenedor

Por último, voy a ejecutar un comando que no tiene que ver directamente con Docker, pero que nos servirá para generar carga y ver el consumo.

$ for i in {1..1000}; do curl -s http://localhost:8080 > /dev/null; doneConstruir Imágenes Personalizadas: Dockerfile

Recordemos que una imagen como un paquete único que contiene todo lo necesario para ejecutar un proceso Y PODEMOS CREAR LOS PROPIOS, en nuestro caso, serían nuestros proyecto en PHP, Node Python, etc; las imágenes personalizadas por nosotros contendrá un entorno Node/Python/PHP, el código de la misma. Para crear nuestras propias imágenes, debemos de crear un archivo especial en nuestro proyecto llamado Dockerfile.

Básicamente, estas son las piezas fundamentales sobre las cuales podemos crear nuestros contenedores para ejecutar aplicaciones. Por ahora, todo puede parecer un poco estático: instalamos imágenes de sistemas operativos o servidores, pero… ¿cómo interactuamos con ellas?

Construyendo Imágenes Personalizadas

Para crear nuestras propias imágenes usamos los famosos archivos llamados Dockerfile. Con estos archivos podemos definir cómo se construye nuestra imagen.

Recuerda: una imagen puede ser cualquier cosa: un sistema operativo, un lenguaje de programación, un servidor… o incluso un proyecto propio. En este caso, vamos a crear una imagen de nuestro proyecto en Flash.

Para construir una imagen personalizada:

- Creamos un Dockerfile en la raíz de nuestro proyecto.

- Definimos las reglas necesarias para que la imagen funcione correctamente.

- Indicamos, si es necesario, qué otras imágenes son requeridas para que nuestra imagen tenga sentido. Por ejemplo, nuestro proyecto en Flash necesita la imagen de Python para funcionar.

Dockerfile

Un Dockerfile es simplemente un archivo de texto que contiene todas las instrucciones necesarias para construir una imagen de Docker. la estructura que tendrá, depende del proyecto y lo que quieras hacer, pero, usualmente cuenta con estos pasos fundamentales:

El Dockerfile es la semilla, la pieza fundamental que nos permite crear nuestras propias imágenes. Por eso, encontrarás muchísimas páginas y ejemplos, porque su funcionamiento es sencillo de comprender: basta con partir de un proyecto base, que puede ser prácticamente cualquier cosa.

1. Crea el Archivo de Instrucciones

En la raíz de tu proyecto, crea un archivo llamado exactamente Dockerfile (con la D mayúscula y sin ninguna extensión).

- Este archivo se crea en la raíz del proyecto, sea PHP, Laravel, CodeIgniter, Flash, FastAPI, Django, Node… lo que sea.

- A partir de allí, definimos un conjunto de reglas. La estructura cambia dependiendo del proyecto, pero en la mayoría de los casos sigue un patrón similar.

2. Define la Imagen Base (FROM)

Especifica el punto de partida de tu imagen usando la instrucción FROM. Esto determina el sistema operativo y el entorno inicial. Por ejemplo, para un proyecto Node.js podrías usar:

FROM node:lts-alpine- En nuestro ejemplo, usamos Python para Flash, o Node para proyectos en Node.

- Si tu proyecto necesita, por ejemplo, SQL, también puedes indicar la imagen de MySQL.

3. Establece el Directorio de Trabajo (WORKDIR)

Con la directiva WORKDIR, defines la carpeta dentro del contenedor donde se ejecutarán todos los comandos posteriores y donde se copiarán tus archivos. Por ejemplo:

WORKDIR /appEste es el lugar donde se instalarán las dependencias, se copiará el proyecto, se ejecutarán comandos y se expondrán puertos.

Por convención, se usa /app, pero puedes nombrarlo como quieras.

4. Copia tus Archivos Locales (COPY)

Utiliza la instrucción COPY para transferir los archivos de tu máquina local al interior de la imagen. Para llevar todos los contenidos del directorio actual (el contexto) al directorio de trabajo del contenedor, harías:

COPY . .- Generalmente copiamos todo el contenido de nuestro proyecto al directorio de trabajo.

5. Ejecuta Comandos de Configuración (RUN)

La instrucción RUN ejecuta comandos durante el proceso de construcción de la imagen, ideal para instalar dependencias o configurar el entorno. Por ejemplo, para instalar dependencias de Node.js:

RUN yarn install --production6. Especifica el Comando de Inicio (CMD)

CMD indica cuál es el comando predeterminado que se ejecutará cuando se inicie un contenedor a partir de esta imagen. Para lanzar una aplicación Node.js:

CMD ["node", "src/index.js"]- Para proyectos de servidor, esto suele incluir instalar dependencias y arrancar la aplicación.

- En Python, por ejemplo, python app.py inicia la aplicación.

- En Node, usaríamos npm install y luego npm start.

7. Informa sobre los Puertos (EXPOSE)

Si tu aplicación está configurada para escuchar en un puerto específico (ej. 3000), usa EXPOSE. Esto le notifica a Docker qué puertos estarán abiertos para la comunicación en tiempo de ejecución.

EXPOSE 3000Ejemplo Completo de Dockerfile

Combinando todas estas directivas, un Dockerfile para una aplicación Node.js se vería así:

Dockerfile

# syntax=docker/dockerfile:1

FROM node:lts-alpine

WORKDIR /app

COPY . .

RUN yarn install --production

CMD ["node", "src/index.js"]

EXPOSE 3000En resumen, el Dockerfile define cómo se construye tu imagen, desde la base hasta los comandos de ejecución y puertos. Cada proyecto requiere adaptaciones específicas, pero la estructura general sigue los pasos que hemos descrito:

- Imagen base (FROM)

- Directorio de trabajo (WORKDIR)

- Copiar archivos del proyecto (COPY)

- Exponer puertos (EXPOSE)

- Ejecutar comandos (RUN o CMD)

- En la siguiente clase veremos cómo elaborar este Dockerfile paso a paso para nuestro proyecto y cómo construir la imagen lista para ejecutarla en un contenedor.

Comando docker build

El comando docker build construye una imagen de Docker (nuestra imagen personalizado) a partir de las instrucciones contenidas en un Dockerfile y un contexto especificado.

$ docker build -t app-flask-chat-01 .- -t, Se utiliza la bandera -t (tag), la imagen resultante recibe un nombre y una etiqueta

- el punto al final (.) significa copiar TODO el proyecto desde el directorio actual que es el que tiene:

App en Flask

Pensando en la estructura anterior, veamos como podemos crear un Dockerfile, para crear una imagen personalizada de un proyecto en Flask:

https://github.com/libredesarrollo/01-jan-chat

Creamos el Dockerfile:

# Usa una imagen base de Python oficial, por ejemplo la versión 3.12 pero mas pequena que la completa que es simplemente python

FROM python:3.12-slim

# Establece el directorio de trabajo dentro del contenedor, puede ser cualquier otro pero, por convension es app

WORKDIR /app

# Copia el archivo de requisitos e instala las dependencias

# --no-cache-dir desactivar el almacenamiento en caché de los paquetes descargados e instalados.

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

# Copia TODO el contenido del proyecto (incluyendo app.py) al directorio de trabajo

COPY . .

# Expone el puerto en el que corre Flask (por defecto 5050)

# if __name__ == '__main__':

# app.run(debug=True, host="0.0.0.0", port=5050)

EXPOSE 5050

# Comando para correr la aplicación

# Usa `python app.py` si modificaste app.run(host='0.0.0.0')

# o usa un comando más robusto si instalaste Gunicorn:

# CMD ["gunicorn", "--bind", "0.0.0.0:5000", "app:app"]

CMD ["python", "app.py"]Paso a Paso: Construyendo el Dockerfile

Ahora sí, comenzamos con el Dockerfile.

Recuerda que puedes inspirarte buscando imágenes base en Docker Hub, la biblioteca oficial.

Como nuestro proyecto está en Python, partiremos de una imagen de Python.

1. Seleccionar la imagen base

Usualmente, partimos de otra imagen base. En este caso, elegimos una imagen de Python, pero para que sea más ligera, usaremos la versión Python Slim:

FROM python:3.12-slimEsta versión es más liviana y eficiente, ya que contiene solo lo esencial para ejecutar Python.

2. Definir el directorio de trabajo

Por convención, usamos /app como directorio principal:

WORKDIR /appAhí se copiará todo el proyecto, y también será donde se ejecuten los comandos definidos más adelante.

3. Copiar dependencias e instalarlas

Lo siguiente es copiar el archivo de dependencias y luego instalarlas:

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txtEsto garantiza que el entorno dentro del contenedor tenga todo lo necesario.

El flag --no-cache-dir evita que se guarde caché, manteniendo la imagen más ligera.

4. Copiar el resto del proyecto

Ahora copiamos el resto de los archivos del proyecto:

COPY . .Esto incluye el código, plantillas, módulos, etc.

5. Exponer el puerto y ejecutar el proyecto

Definimos el puerto (en mi caso, 5050) y cómo se ejecutará la aplicación:

EXPOSE 5050

CMD ["python", "app.py"]Construir y Ejecutar la Imagen

Con el Dockerfile listo, el siguiente paso es construir la imagen.

Tenemos la estructura para crear la imagen, falta construir la imagen personalizado de nuestra aplicación, para ello:

$ docker build -t app-flask-chat-01 .- -t, Se utiliza la bandera -t (tag), la imagen resultante recibe un nombre y una etiqueta

- el punto al final (.) significa copiar TODO el proyecto desde el directorio actual que es el que tiene:

__pycache__ chat_routes.py llm_service.py templates

app.py Dockerfile requirements.txt test.py

Este comando crea la imagen, leyendo las instrucciones del Dockerfile.

Puedes verificarla en Docker Desktop o con:

$ docker imagesEjecutar el Contenedor

Ahí verás tu imagen recién generada.

Y para crear el contenedor de nuestra imagen personalizada:

$ docker run -d -p 5050:5050 --name flask-app-contenedor app-flask-chat-01En cualquier comento, puedes ver el log del contenedor:

$ docker logs flask-app-contenedor Ideal por si el proyecto tiene errores, y deberías de ver algo como esto:

* Running on all addresses (0.0.0.0)

* Running on http://127.0.0.1:5050

* Running on http://172.17.0.2:5050

Press CTRL+C to quit

* Restarting with stat

* Debugger is active!

* Debugger PIN: 148-371-654Con Gunicorn

Si queremos desplegar nuestra aplicación en producción, esto se convierte en un problema.

El hecho de que Flask indique que es un servidor de desarrollo significa que no está optimizado para entornos productivos, por lo que debemos utilizar un servidor apropiado para este tipo de despliegues.

En el caso de las aplicaciones desarrolladas con Flask, necesitamos emplear un servidor WSGI (Web Server Gateway Interface) orientado a producción.

Y justamente, uno de los más usados para este propósito es Uvicorn.

Sustituyendo el servidor de desarrollo por Uvicorn

Hasta ahora hemos estado utilizando el servidor de desarrollo, pero queremos hacerlo bien y simular un entorno de producción.

Para ello, comenzamos instalando el paquete de Uvicorn en nuestro proyecto Flask.

Agregamos requirements.txt:

$ pip install gunicornY

$ pip freeze > requirements.txtEl Dockerfile:

CMD ["gunicorn", "--workers", "4", "--bind", "0.0.0.0:5050", "app:app"]

gunicorn -b 0.0.0.0:$PORT run:appExplicando los parámetros:

- --workers 4: indica el número de workers (procesos) que manejarán las peticiones de los usuarios.

Puedes ajustar este valor según los recursos del servidor. - --host 0.0.0.0: define la dirección donde se ejecutará la aplicación dentro del contenedor (el equivalente a localhost).

- --port 5050: especifica el puerto del proyecto.

El resto del archivo Dockerfile permanece igual.

Luego reconstruyes la imagen Docker y levantamos el servidor, tal cual hicimos antes:

$ docker build -t gapp-flask-chat-01 .

$ docker run -d -p 5050:5050 --name gflask-app-contenedor gapp-flask-chat-01App en Django

Pensando en la estructura anterior, veamos como podemos crear un Dockerfile, para crear una imagen personalizada de un proyecto en Flask:

https://github.com/libredesarrollo/coruse-book-django-store

Creamos el Dockerfile:

# Imagen base

FROM python:3.12-slim

# Evitar que Python guarde pyc y buffer stdout

ENV PYTHONDONTWRITEBYTECODE=1

ENV PYTHONUNBUFFERED=1

# Carpeta de trabajo

WORKDIR /app

# Copiar dependencias primero

COPY requirements.txt .

# Instalar dependencias

RUN pip install --no-cache-dir -r requirements.txt

# Copiar todo el código

COPY . .

# Exponer puerto de Django

EXPOSE 8000

# Comando de inicio (Gunicorn para producción)

CMD ["gunicorn", "app.wsgi:application", "--bind", "0.0.0.0:8000"]En donde app, es el nombre del proyecto en Django, en caso del proyecto anterior quedarías así:

CMD ["gunicorn", "mystore.wsgi:application", "--bind", "0.0.0.0:8000"]Es donde se ubican los archivos de:

mystore/wsgi.py

Y

mystore/asgi.py

De tu proyecto.

Definimos un par de variables de entorno adicionales:

🧩 ENV PYTHONDONTWRITEBYTECODE=1

Indica a Python que no genere archivos .pyc (bytecode compilado).

Normalmente, Python crea archivos .pyc junto a tus .py para acelerar futuras ejecuciones.

En Docker eso no tiene sentido, porque cada vez que reconstruyes la imagen se vuelve a generar todo.

🧩 ENV PYTHONUNBUFFERED=1

Hace que Python escriba directamente a la salida estándar (stdout), sin guardar en buffer.

Sin esto, los logs pueden “retrasarse” o no verse en tiempo real dentro de docker logs.Con esto, los print() y los logs de Django o Flask aparecen inmediatamente en el terminal o en docker logs -f.

Estas mismas variables de entorno las puedes emplear también en tus otros proyectos en Python, inclusive en el de Flask que vimos anteriormente para optimizar las imágenes.

Finalmente, si quieres emplear el servidor local:

CMD ["python", "manage.py", "runserver", "0.0.0.0:8000"]Y al igual que antes, generamos las imagen y el contenedor:

$ docker build -t app-django-01 .

$ docker run -d -p 8000:8000 --name django-app-contenedor app-django-01Conectando Docker con la Máquina Local: Explicación Práctica: host.docker.internal

Vamos a conocer un mecanismo que tenemos en Docker que nos permite, en pocas palabras, conectarnos desde un contenedor hacia nuestra máquina local. Es decir, desde un entorno aislado (el contenedor) podemos acceder a servicios que se ejecutan directamente en nuestro host.

El ejercicio es simple, tengo una app en Django con los CORS configurados ejecutándose en mi localhost (nada de Docker) y quiero conectar una app en Flask ejecutándose en un contenedor; para poder conectarse a nuestro host (nuestra PC) desde un contenedor en Mac y Windows tenemos el siguiente DNS:

Intentando con host.docker.internal

Existe un mecanismo especial: host.docker.internal, un DNS interno que permite a los contenedores comunicarse con el host.

Así que regeneramos la imagen agregando la siguiente línea al momento de generar la imagen y el contenedor:

--add-host=host.docker.internal:host-gateway

docker build -t app-flask-chat-01 .

docker run -d -p 5050:5050 --add-host=host.docker.internal:host-gateway app-flask-chat-01Antes de esto, desde la app en Flask, nos conectamos a la app Django mediante:

# response = requests.get('http://127.0.0.1:8000/store/product')

response = requests.get('http://host.docker.internal:8000/store/product')Con esto, ahora podremos conectarnos de un contenedor a nuestro host de una manera sencilla

Esto habilita la comunicación con el host desde dentro del contenedor.

Tras ejecutar nuevamente, vemos que el error cambia: ahora obtenemos un 403 (Forbidden) en lugar del 500 anterior.

Volumenes

La siguiente evolución lógica en este curso es conocer los volúmenes. Ya no solo trabajamos con imágenes y contenedores, sino también con una nueva herramienta: los volúmenes.

¿Qué son los volúmenes?

Un volumen es una forma de persistir datos fuera del contenedor. Hasta ahora, cuando eliminábamos un contenedor, se perdía toda la información que contenía. Con los volúmenes, esos datos se mantienen independientemente del ciclo de vida del contenedor.

- Básicamente, funciona como un pendrive o disco duro externo: los datos se almacenan en un espacio independiente, fuera del contenedor.

- Esto nos permite desarrollar sin tener que generar nuevas imágenes constantemente para mantener información.

Donde partimos

De momento, hemos visto algunos conceptos básicos sobre cómo trabajar con Docker. Lo principal ha sido aprender sobre imágenes, contenedores y cómo podemos manipularlos: el típico CRUD de crear, eliminar, listarlos, etcétera.

También vimos cómo tomar una imagen para ejecutarla en un contenedor, configurarla mediante los puertos, y otras opciones. Básicamente, eso es lo que hemos hecho hasta este punto.

Aparte de eso, revisamos otra sección, ya que con solo esos conocimientos no es suficiente. Hasta ahora estábamos “jugando”: creamos una imagen, levantamos un contenedor, pero realmente no estábamos utilizando nada de manera práctica. Por ejemplo, levantamos Nginx, pero no había nada ejecutándose allí.

Problemas al trabajar con Docker en desarrollo

Entonces surge la pregunta: ¿cómo podemos, como programadores, utilizar Docker para nuestras propias soluciones?

Ahí es donde entra este curso, que busca enseñarte a levantar tus proyectos en Docker de manera práctica. Vimos un preámbulo en el que, mediante el Dockerfile, podemos tener nuestro propio proyecto. Revisamos ejemplos como una aplicación en Flask y otra en Django, agregando ciertas reglas para levantar la aplicación en Docker.

Hasta aquí todo perfecto, pero si has experimentado un poco con Docker, habrás notado algunos problemas:

- Docker puede usarse tanto en producción como en desarrollo.

- En producción, no pasa tanto: simplemente levantamos un contenedor sobre un servidor ya configurado (por ejemplo, Unicorn).

- En desarrollo, es diferente: cada cambio que hagamos en la aplicación requiere generar nuevamente la imagen (docker build) y levantar el contenedor (docker run).

Esto hace que el desarrollo sea poco funcional: cada cambio implica un proceso laborioso, eliminar contenedores anteriores, recrearlos, verificar errores, y volver a intentar.

Creación y uso de volúmenes

Vamos a probarlo paso a paso:

Abrimos la terminal y verificamos que Docker está ejecutándose.

Revisamos contenedores, imágenes y volúmenes. Todo forma parte del ecosistema de Docker.

Creamos un volumen usando:

$ docker volume create my_volumeAhora tenemos un volumen vacío, como un pendrive recién creado. Podemos listar los volúmenes con:

$ docker volume lsMontando el volumen en un contenedor

Para que tenga sentido, un volumen debe usarse con un contenedor. Por ejemplo:

$ docker run -it --name c1 -v my_volume:/data ubuntu- -v my_volume:/data indica que el volumen my_volume se montará en la carpeta /data dentro del contenedor.

Esto crea un espacio persistente donde se pueden guardar archivos, datos de la aplicación, logs, etc.

Dentro del contenedor:

$ cd /data

$ ls

$ echo "Hola desde contenedor" > archivo.txt

$ cat archivo.txtSi eliminamos el contenedor y levantamos uno nuevo:

$ docker run -it -v mi_volumen:/data ubuntu bashVeremos que la carpeta /data sigue ahí con los mismos archivos, porque los datos están persistiendo en el volumen, no en el contenedor.

Docker Compose: ¿Qué demonios es esto y qué pasó con los volúmenes?

¿Qué era lo que estábamos hablando anteriormente? Recuerda que el objetivo de este bloque, de esta sección, es poder utilizar Docker, pero no como una herramienta de deployment en producción, sino para trabajar perfectamente con nuestras aplicaciones durante el desarrollo.

La idea es que, por ejemplo, cuando tengamos cambios en el código, estos se puedan reflejar automáticamente en el contenedor y verlos por pantalla. Con lo que ya hemos visto de imágenes, contenedores y demás, no es suficiente; eso son solo las herramientas básicas, pero necesitamos más mecanismos.

Recordatorio: los volúmenes

Anteriormente vimos una pieza clave: los volúmenes. En resumidas cuentas —y lo viste en el video anterior— los volúmenes permiten persistir datos, lo cual es fundamental para lo que estamos mencionando. Pero necesitamos aún otra pieza clave: Docker Compose, que internamente ampliará el uso de los volúmenes para poder inyectar los cambios que estamos comentando.

¿Qué es Docker Compose?

Docker Compose es una herramienta que viene instalada junto con Docker (igual que pasa con pip cuando instalas Python o npm cuando instalas Node).

Básicamente, Compose permite emplear múltiples contenedores de Docker dentro de una sola aplicación.

Por ejemplo, aquí tenemos una aplicación Flask —la que vamos a construir ahora— donde utilizamos un contenedor para Flask (es decir, una imagen de Python) y también necesitamos Redis. Por lo tanto, son dos contenedores que deben comunicarse entre sí.

¿Y cómo los comunicamos?

Para eso está Compose: permite hacer esto de forma muy sencilla mediante un archivo de configuración.

Compose nos deja agregar todas las dependencias que necesite nuestro proyecto: Redis, MySQL, PostgreSQL, etc. Todo lo que necesites como contenedor.

Resumen de la definición

Docker Compose es una herramienta que permite definir y ejecutar aplicaciones con múltiples contenedores.

Ejemplo: un contenedor para Flask y otro para Redis.

Uso básico de Docker Compose

Compose tiene sus comandos típicos, lo que sería un pequeño “CRUD”: comandos para crear, parar, ver logs y listar.

En la documentación oficial puedes ver los comandos principales:

- compose up → levantar la aplicación

- compose down → detener y desmontar

- logs → ver registros

- ps → ver procesos/servicios activos

Todo lo típico.

En términos simples: Compose es un mecanismo para que desde un solo proyecto podamos utilizar múltiples contenedores, que al final son las dependencias de nuestra aplicación.

El proyecto de ejemplo con Flask y Redis

Este es el proyecto que vamos a montar como ejercicio. Es un ejemplo muy sencillo: una aplicación Flask que se conecta a Redis.

En el repositorio encontrarás:

- Dependencias

- Dockerfile

- Archivo docker-compose.yml

- Código fuente

- Configuraciones adicionales

https://github.com/libredesarrollo/flask-redis-docker

El proyecto consiste en un contador almacenado en Redis, de manera que cada vez que recargamos la página, Redis incrementa un valor y Flask lo muestra. Redis se utiliza aquí como caché, aunque también sirve para almacenar datos temporalmente, manejar sesiones, colas, etc.

El retorno de Flask simplemente muestra por pantalla el valor incrementado.

Dockerfile y consideraciones

En el Dockerfile tenemos lo mismo de siempre:

- Imagen base de Python (la versión "alpine", más ligera).

- Directorio de trabajo.

- Instalación de dependencias (incluyendo las de Redis).

- Copia del proyecto completo al contenedor.

- Comando de ejecución.

Algunas variantes del proyecto usan flask run, que es lo recomendado para desarrollo, pero por ahora usaremos la forma más básica.

El archivo docker-compose.yml

Aquí viene la parte importante. Para usar Compose necesitamos este archivo específico. Puede llamarse docker-compose.yml o dockercompose.yml (con o sin guion bajo).

Servicios

En Compose, cada bloque de configuración representa un servicio, que básicamente es un contenedor.

Ejemplo de la estructura básica:

- web: servicio principal (Flask).

- redis: servicio para Redis.

En web se define:

- build: . → que construya la imagen a partir del Dockerfile.

- Puertos expuestos.

- Dependencias.

En redis simplemente definimos la imagen que vamos a usar (en este caso, la versión alpine de Redis).

Agregar otros servicios

Si quisiéramos usar MySQL, simplemente agregamos:

mysql:

image: mysql

...Compose permite agregar tantos servicios como necesite nuestro proyecto.

Levantando la aplicación

Si no tenemos contenedores, imágenes o volúmenes previos, Compose los va a generar.

El comando principal:

$ docker compose upEste comando:

- Lee el archivo docker-compose.yml.

- Construye las imágenes necesarias (si no existen).

- Crea los contenedores.

- Los levanta en el orden correcto.

El archivo Compose se convierte en la pieza clave del proyecto.

La aplicación Flask se levanta correctamente y ya podemos acceder a ella. Cada recarga incrementa el contador almacenado en Redis.

Problema pendiente: sincronización de cambios

Por ahora hacemos cambios en el proyecto y no se sincronizan con el contenedor.

Esto lo resolvemos en la siguiente clase con la parte de sincronización (volúmenes y docker watch).

Consideraciones importantes

- Primero configura el Dockerfile.

Si algo falla allí, Compose tampoco funcionará. - La base es siempre la aplicación.

Si la app no levanta, el contenedor construido desde el Dockerfile tampoco lo hará, y Compose mucho menos. - Compose es una capa superior.

Si algo falla abajo (app → Dockerfile → Compose), debes resolver el problema desde la base hacia arriba.

Docker Compose

Vamos a ver un aspecto fundamental para poder emplear Docker como desarrolladores, que es la parte de sincronización o watch (observador). En pocas palabras, lo que buscamos es que, cuando hagamos cambios en nuestro proyecto, estos se reflejen automáticamente en la aplicación.

Actualmente, como vimos en el video anterior, al modificar ciertos archivos (por ejemplo, un archivo .py), los cambios no se reflejan en pantalla porque no hemos activado el modo watch.

Empleamos Docker Compose principalmente por dos razones cruciales:

- Comunicación de Contenedores: Permite que diferentes servicios de nuestra aplicación (como el contenedor de la Base de Datos, el contenedor de Redis, y el contenedor de nuestra Aplicación Flask) se comuniquen entre sí de manera sencilla.

- Persistencia de Datos: Utiliza Volúmenes internos, lo cual garantiza que los datos de nuestra aplicación persistan aun cuando eliminemos o detengamos los contenedores.

- Esto último es la clave para que, por fin, podamos emplear Docker para el desarrollo y no limitarnos a usarlo solo en producción, como se hacía anteriormente.

🧩 La Estructura de Capas de Docker

Docker Compose se sitúa en la capa superior de las herramientas de Docker, construyendo sobre la base ya existente:

- Base de Docker: Contenedores, Imágenes, Volúmenes (lo básico).

- Docker File: La forma de acceder y construir estas imágenes y contenedores.

- Docker Compose: Una capa superior que coordina todo lo anterior para gestionar múltiples servicios interconectados.

Configuración Inicial

Para activar el watch en Docker, seguimos la guía que estamos utilizando. Recordemos que previamente levantamos nuestros servicios con Docker Compose, como por ejemplo flask y redis. Esto también aplica a bases de datos tradicionales como MySQL.

El detalle importante es el modo watch, que permite que los cambios en el código fuente se sincronicen automáticamente. Para activarlo:

- Debemos agregar líneas de código específicas en el archivo Dockerfile y modificar el comando de ejecución.

- En proyectos como Laravel, solíamos tener un comando dev y otro watch. En Flask, se recomienda usar flask run, aunque esto puede variar según la configuración del proyecto.

Diferencia entre Modo Watch y No Watch

- No Watch: Ejecuta la aplicación en modo normal, sin sincronización automática.

- Watch: Activa el modo desarrollador con sincronización de cambios en tiempo real desde el directorio de trabajo.

Es muy importante que el target del directorio coincida exactamente con el del Dockerfile, de lo contrario la sincronización no funcionará.

Activando Watch en Docker Compose

Una vez configurado:

compose.yaml

services:

web:

build: .

ports:

- "5050:5050"

develop:

watch: # Modo Watch

- action: sync

path: .

target: /app # AQUI SYNC!!

redis:

image: "redis:alpine"Podemos iniciar Docker Compose con la opción watch:

$ docker-compose up --watchO también:

$ docker-compose watchAmbas opciones funcionan de manera equivalente y permiten activar la sincronización. Antes de iniciar, es recomendable eliminar contenedores y volúmenes previos para evitar conflictos:

$ docker-compose down -vLuego, levantamos los servicios y verificamos que los cambios en el código fuente se reflejen automáticamente.

Verificación del Watch

Cuando hacemos cambios en el código fuente, por ejemplo, en un archivo .py o .js, debemos ver que los cambios se detectan y se reflejan en la aplicación en tiempo real. Si no es así:

- Revisa que el target del directorio coincida con la configuración del Dockerfile:

- compose.yaml target: /app # AQUI SYNC!!

- Dockerfile WORKDIR /app

- Asegúrate de que el comando flask run o equivalente esté correctamente configurado para el modo desarrollador.

- Comprueba que no haya conflictos de contenedores o variables de entorno.

Consideraciones Especiales

- En proyectos con Flash, el modo watch puede variar ligeramente, pero la idea es la misma: activar la sincronización desde el directorio de trabajo.

- Configura correctamente las variables de entorno dentro del contenedor, ya que Docker no toma las de la terminal local.

- Evita tener configuraciones duplicadas que puedan interferir con el modo watch.

Resumen

Con estas configuraciones:

- Modificamos el archivo docker-compose.yml y Dockerfile.

- Activamos el modo watch para sincronización automática.

- Eliminamos contenedores y volúmenes anteriores.

- Ejecutamos Docker Compose con la opción watch.

- Verificamos que los cambios en el código se reflejen en la aplicación en tiempo real.

Con esto, ya podemos usar Docker como entorno de desarrollo efectivo, detectando cambios al instante y trabajando de manera más eficiente.

Separación de Servicios en Docker

Otra característica muy interesante de Docker es la posibilidad de separar los servicios.

¿Qué es un servicio?

Básicamente, un servicio es cualquier elemento que nuestra aplicación necesita para funcionar. Por ejemplo:

- Nuestra aplicación en Flask, que se genera a partir del Dockerfile.

- Redis, como servicio adicional.

Así de simple: todo lo que no forma parte directamente de la aplicación principal se considera un servicio.

Nota: En algunos casos puede aparecer un mensaje indicando que instales extensiones para Docker. No es obligatorio; lo menciono solo porque me apareció a mí.

Creación de un archivo para servicios

Para organizar los servicios, podemos crear un archivo adicional con extensión .yml, a nivel hermano del docker-compose.yml principal, aunque también se puede colocar en una carpeta.

En este archivo colocamos los servicios que no forman parte de la aplicación principal. Por ejemplo, nuestra aplicación en Flask sería la aplicación principal, mientras que Redis, MySQL, PostgreSQL, Nginx u otros serían los servicios.

En el ejemplo que estamos viendo, el archivo se llama infra.yml (abreviatura de infraestructura), pero puedes usar cualquier nombre. La idea es:

- Mantener los archivos más limpios.

- Evitar errores por modificar algo por accidente.

- Facilitar la reutilización de servicios en otros proyectos.

Ventajas de separar los servicios

- Organización: Mantienes tus archivos más claros y fáciles de leer.

- Reutilización: Puedes copiar servicios a otros proyectos sin duplicar toda la configuración.

- Flexibilidad: Puedes añadir o quitar servicios sin afectar la aplicación principal.

Convenciones de nombres: infra para infraestructura, redis, postgres, nginx, cache, proxies, bases de datos, etc. No es obligatorio, pero ayuda a mantener consistencia.

Implementación práctica

- Duplica tu archivo compose.yml si quieres tener una referencia limpia.

- Crea un nuevo archivo llamado infra.yml.

- Dentro de este archivo, define tus servicios. Por ejemplo:

infra.yaml

services:

redis:

image: "redis:alpine"

ports:

- "6379:6379"En el archivo principal (compose.yml), incluye el archivo de servicios con include o extends, según tu versión de Docker Compose:

include:

- infra.yaml

services:

web:

build: .

ports:

- "5050:5050"

develop:

watch: # Modo Watch

- action: sync

path: .

target: /app # AQUI SYNC!!Borra imágenes y contenedores previos para hacer una prueba limpia:

$ docker-compose down -vO

$ docker compose watchEjecuta docker-compose up y verifica que todos los servicios se levanten correctamente. Por ejemplo, verás:

- Contenedor de la aplicación.

- Contenedor de Redis.

- Cualquier otro servicio definido.

✔ flaskredis-web Built 0.0s

✔ Container flaskredis-redis-1 Star... 0.4s

✔ Container flaskredis-web-1 Starte... Comandos útiles (watch up down ps)

A continuación, se presenta un resumen de los comandos más útiles para la gestión de tus servicios en un entorno de desarrollo:

- Comando Función Descripción

- docker compose up Iniciar Servicios Inicia todos los servicios definidos en el docker-compose.yml.

- docker compose up -d Ejecución en Segundo Plano Inicia los servicios en modo Detached (segundo plano), liberando la terminal para otros usos.

- docker compose ps Verificar Estado Muestra qué contenedores están actualmente en ejecución (activos) para el proyecto.

- docker compose stop Detener Servicios Detiene todos los contenedores en ejecución de manera controlada.

- docker compose down Detener y Eliminar Detiene los contenedores y elimina la red asociada, la opción más limpia al finalizar.

- docker compose --help Ayuda Muestra todos los comandos disponibles (útil para explorar opciones adicionales).

Ejemplo Práctico: Si ejecutamos docker compose up -d y luego docker compose ps, la terminal nos indicará que Redis y nuestro proyecto Flask se están ejecutando, permitiéndonos seguir trabajando:

NAME IMAGE COMMAND SERVICE CREATED STATUS PORTS

flaskredis-redis-1 redis:alpine "docker-entrypoint.s…" redis 3 days ago Up 2 seconds 6379/tcp

flaskredis-web-1 flaskredis-web "flask run" web 3 days ago Up 2 seconds

El proyecto de ejemplo con Django y MySQL

Vamos a configurar Docker Compose para un proyecto en Django que requiere múltiples servicios, en este caso, MySQL.

Anteriormente, cuando usábamos SQLite (una base de datos interna), un simple docker build era suficiente. Sin embargo, cuando necesitas integrar servicios externos como Redis o MySQL, estás lidiando con múltiples contenedores.

- Un servicio = docker build y docker run

- Varios servicios = Docker Compose

1. Configuración de Django y Dependencias

Para usar MySQL en Django, primero debemos instalar las dependencias necesarias y configurar Django para que se conecte a la base de datos.

- Dependencias: Asegúrate de agregar el conector de MySQL a las dependencias de tu proyecto (por ejemplo, mysqlclient).

- Configuración de la Base de Datos: En el archivo de configuración de Django, utiliza variables de entorno para la conexión. Esto es crucial, ya que estas variables se definirán en Docker Compose.

# Ejemplo en settings.py

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'NAME': os.environ.get('MYSQL_DATABASE'),

'USER': os.environ.get('MYSQL_USER'),

'PASSWORD': os.environ.get('MYSQL_PASSWORD'),

'HOST': 'db', # Importante: 'db' es el nombre del servicio en Docker Compose

'PORT': '3306',

}

}2. Creación del Archivo docker-compose.yml

El archivo docker-compose.yml definirá dos servicios: la base de datos (db) y la aplicación Django (web).

A. Servicio de MySQL (db)

La configuración de MySQL requiere definir la imagen, variables de entorno, puertos y, crucialmente, los volúmenes para asegurar la persistencia de los datos.

docker-compose.yml

version: "3.9"

services:

db:

image: mysql:8.0

container_name: mysql_db

restart: always # Docker intentará reiniciar el contenedor siempre que se detenga, independientemente de la razón (incluyendo cierres limpios, fallos de aplicación o reinicios del propio Docker Daemon/Servidor).

environment:

MYSQL_ROOT_PASSWORD: root

MYSQL_DATABASE: django_db

MYSQL_USER: django_user

MYSQL_PASSWORD: django_pass

ports:

- "3306:3306"

volumes:

- mysql_data:/var/lib/mysql # es la carpeta de datos -nuestras tablas- es la que guardamos en un volumen para que no se pierdan los datos.

web:

***

volumes: # En Docker Compose, el archivo se divide en secciones de nivel superior. La sección volumes: (al mismo nivel que services:) se utiliza para declarar y definir los volúmenes con nombre que Docker Compose debe gestionar.

mysql_data:- image: Usamos la imagen oficial de MySQL.

- environment: Definimos variables de entorno clave (usuario, password, nombre de la base de datos) para que MySQL se configure al iniciar. Estos valores se tomarán del archivo .env.

- volumes: El directorio /var/lib/mysql es donde MySQL almacena los datos (tablas, binarios). Al mapearlo a un volumen llamado db_data, aseguramos que los datos persistan incluso si el contenedor se detiene o se elimina.

- volumes (Directiva Final): Es obligatorio declarar los volúmenes al final del archivo al mismo nivel que services.

B. Servicio de Django (web)

El servicio web contendrá la aplicación Django.

docker-compose.yml

version: "3.9"

services:

db:

***

web:

build: .

container_name: django_app

command: python manage.py runserver 0.0.0.0:8000

# command: python app/manage.py runserver 0.0.0.0:8000 # ruta mala

volumes:

- .:/app # alternativa INmoderna al watch para que inyecte los cambios en desarrollo

ports:

- "8000:8000"

depends_on:

- db

environment: # en settings esta establecido para leer os.environ.get('DB_NAME', 'django_db'),

DB_HOST: db

DB_PORT: 3306

DB_NAME: django_db

DB_USER: django_user

DB_PASSWORD: django_pass

***- build: Usa el Dockerfile local para construir la imagen de Django.

- depends_on: db: Fundamental para asegurar que el contenedor de la aplicación no intente conectarse a MySQL antes de que este esté levantado.

- environment: Exporta las variables de entorno de MySQL necesarias para que la aplicación Django las consuma.

- volumes: .:/app: Sincroniza el código local con el contenedor, permitiendo la inyección de cambios (hot-reloading).

3. Levantamiento y Ejecución de Comandos

1. Levantar los Servicios

Para levantar ambos contenedores (Django y MySQL) en modo detach (segundo plano):

$ docker compose up -dAl acceder a la aplicación en el navegador, verás un error indicando que las tablas no existen, lo cual es correcto, ya que la imagen de MySQL no es mágica.

2. Ejecutar Migraciones (Comandos Externos)

Necesitamos una forma de ejecutar comandos dentro de un contenedor. Para esto usamos docker compose run web.

$ docker compose run web python manage.py migrate- docker compose run web: Ejecuta un comando único en un nuevo contenedor basado en el servicio especificado.

- docker compose run web: El servicio en el que queremos ejecutar el comando.

- python manage.py migrate: El comando de Django a ejecutar.

Tras ejecutar las migraciones, la aplicación funcionará correctamente, ya que la estructura de tablas se ha creado en el contenedor de MySQL.

⚠️ 4. Pruebas y Solución de Problemas (Debugging)

Puedes realizar pruebas comentando secciones para entender su funcionalidad y cómo Docker Compose maneja los errores.

- Fallo Comentado Efecto en la Aplicación Diagnóstico

- Volúmenes (volumes: .:/app) Los cambios en el código local no se reflejan en la aplicación. Indica que la sincronización del código está desactivada.

- command: python app/manage.py (Ej. Error de sintaxis) El servidor Django no arranca, solo ves la traza de MySQL en la consola. Error de ejecución en el command. El contenedor Django muere al intentar ejecutar el comando fallido.

- environment (Variables de MySQL) La aplicación muestra un error de "Access Denied" o "Can't connect". Problemas de conexión a la base de datos (credenciales, host o puerto).

Puedes descomentar/comentar los bloques de código del docker-compose.yml para que realices estas pruebas; recuerda que puedes ver los logs del contenedor mediante:

$ docker compose logs -f <containerName>

$ docker compose logs -f django_app

$ docker compose logs -f mysql_dbLaravel Sail

Laravel Sail es la forma oficial en Laravel que tenemos para usar Docker en Laravel, es decir, poder Dokerizar una aplicación en Laravel, este tema es tratado en el artículo compartido antes.